新闻资讯

体育游戏app平台简短在ρ=75%到80%之间-开云官网kaiyun皇马赞助商 「中国」官方网站 登录入口

梦晨 发自 凹非寺

量子位 | 公众号 QbitAIDeepSeek节前开动蓄力!

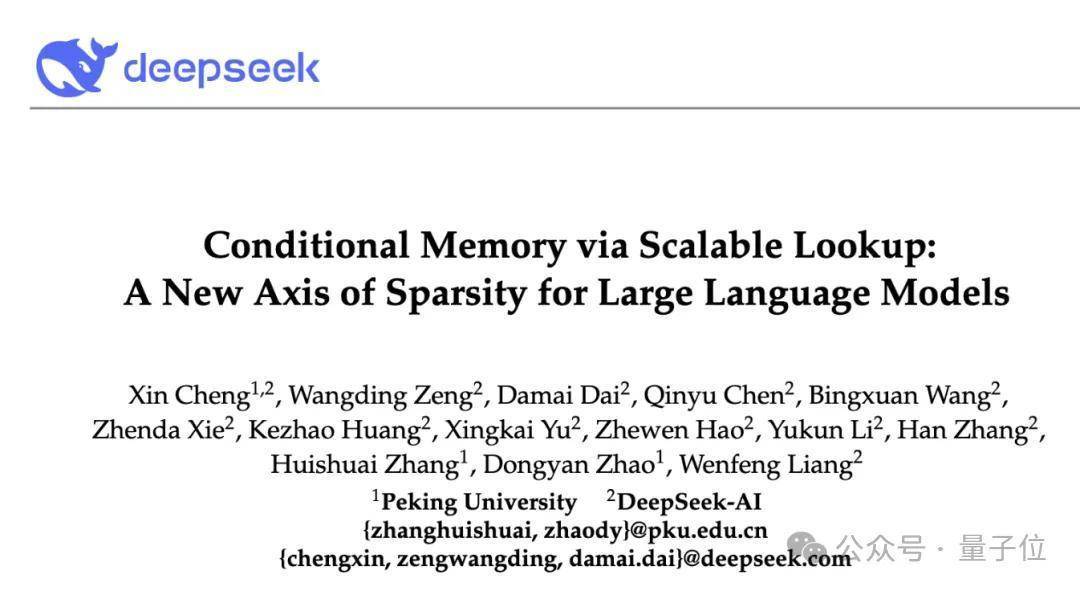

最新论文径直给Transformer加上“条款驰念”(Conditional Memory),补上了原生枯竭的学问查找机制。

论断中明确写谈:咱们将条款驰念视为下一代稀少模子不可或缺的建模原语。

照旧梁文锋签字,并与北京大学王选所赵东岩、张辉帅团队配合。

论文中不仅忽视了条款驰念这个全新范式,并给出了具体竣事决策Engram模块,实验中让27B参数碾压同范畴纯MoE模子,以致变相教养了大模子的推理才略:

让本来Transformer要用6层小心力才气干的简便任务压缩到1-2层责罚,省出来的资源就不错用于更难的推理任务了。

条款驰念的旨趣其实也相等“原始”:不靠预计,总结查表,用上了传统-gram措施。

给大模子一个浩大的词表,特殊存那些固定的实体称呼和两三个词的短语,不论词表多大,找信息齐是O(1)速率。

枢纽就在于,如斯前大模子期间的玩法,DeepSeek奈何解决传统N-gram模子存储爆炸和多义性问题,又是让它和当代Transformer集合起来的?

让小心力干“挑夫活”太浪费了团队的中枢不雅察是,谈话建模其实包含两种性质十足不同的任务,一种是需要深度动态预计的组合推理,另一种则是检索静态学问。

问题在于,现存的Transformer架构枯竭原生的学问查找机制。

当模子需要识别一个实体时,它得奢靡好几层小心力和前馈网罗,逐层强迫特征,最终才气完成。

论文中援用了一个具体案例:”Diana, Princess of Wales”

模子需要经过6层才气完成这个识别经由,前几层还在纠结”Wales是英国的一个地区”、”Princess of Wales是某种头衔”这些中间情景,最终才气“想起来”这是指戴安娜王妃。

骨子上是在用奋斗的运行时预计来重建一个静态查找表,那些本不错用于更高层推理的网罗深度,被浪费在了识别主张这种“挑夫活”上。

总结查表,总结N-gramEngram的预备念念路终点径直:既然经典的N-gram模子就能用O(1)的时辰复杂度拿获这些局部依赖,那为什么不把这个才略径直镶嵌Transformer?

具体竣事上,团队在原有的Transformer层之间插入Engram模块。每个位置的输入会触发一次哈希查找:把现时token和前边几个token构成的N-gram映射到一个浩大的镶嵌表中,径直取出对应的向量。

为了处理哈希粉碎和多义性问题,团队引入了高下文感知的门控机制,用现时的荫藏情景当作Query,检索到的驰念当作Key和Value,预计一个0到1之间的标量门控值。

要是检索到的内容和现时高下文不匹配,门控值就趋近于零,终点于自动屏蔽噪声。

下图中,样式越深阐明Engram越判断现时文本片断是“固定静态模式”,倾向于调用驰念库中的对应信息。

样式越浅代表这段文本越动态机动,主要靠模子的小心力机制处理。

比如只看到“张”是一个常见姓氏,然而“张仲景”三个字凑一谈即是固定历史东谈主物实体了。

接下来还要解决传统N-gram模子的两个痛点。

语义重复,并吞个词的不同面容(比如 Apple、apple、Äpple)被当成不同 token,浪费存储。

存储爆炸,所有这个词可能的 N-gram(比如2词、3词组合)数目太多,比如128k词表就要存128k^3种组合,径直存储根柢存不下。

DeepSeek团队最初压缩tokenizer,把语义谈判但面容不同的token归为一类,128k词表的灵验范畴径直减少23%,谈判语义的token聚在一谈,查找更高效。

再用多个哈希函数把N-gram映射成embedding表的索引,

这既解决了存储爆炸:不论有若干种N-gram,齐通过哈希函数映射到一个固定大小的embedding内外,表的大小是质数。

又减少查找粉碎:给每种N-gram阶数(比如2-gram、3-gram)配K个不同的哈希头,每个哈希头对应一个孤苦的embedding表,把所有这个词N-gram阶数、所有这个词哈希头取出来的 embedding向量拼在一谈,变成最终的“驰念向量”eₜ,供后续模块使用。

U型弧线:MoE和驰念的最优配比

论文最中枢的部分是对”稀少性分派问题”的系统征询。

团队预备了一个严格的实验框架:固定总参数目和每token的激活参数目(也即是预计量),然后在MoE内行和Engram驰念之间重新分派”闲置参数”预算。

分派比例ρ从100%(纯MoE)徐徐降到40%,实验遗弃画出了一条了了的U型弧线:

纯MoE反而不是最优解,把简短20%到25%的稀少参数预算分给Engram驰念时,模子考据集loss达到最低点。

在100亿参数范畴下,最优确立比纯MoE基线的loss裁汰了0.0139。

更关键的是,这个最优分派点在不同预计预算下齐终点知道,简短在ρ=75%到80%之间。

团队阐明注解了U型弧线两头的含义:

MoE主导时,模子枯竭静态模式的专用驰念,被动通过网罗深度和大批预计来低效重建。

Engram主导时,模子丢失了条款预计才略,在需要动态推理的任务上发扬下跌。

总之,驰念无法替代预计,预计也无法高效模拟驰念。

27B范畴考据:推理才略教养超预期按照U型弧线的率领,团队把Engram彭胀到更大参数范畴进行考据,并对比纯MoE模子和纯密集模子。

所有这个词模子锤真金不怕火条款一致,激活参数目齐是38亿,锤真金不怕火token齐是2620亿,互异仅在 “稀少才略分派”。

Dense-4B:纯密集模子。

MoE-27B:纯搀和内行模子,72个路由内行+2个分享内行,所有这个词稀少参数齐给MoE。

Engram-27B:MoE+Engram搀和模子,55个路由内行+2个分享内行,把5.7B稀少参数分派给Engram驰念模块。

Engram-40B:进一步彭胀Engram模块,保合手内行数目不变,Engram驰念参数增至 18.5B,总参数39.5B。

遗弃MoE-27B和Engram-27B对比,学问密集型任务的教养在预期之内:比如MMLU教养3分,CMMLU教养4.0分,TriviaQA教养1.9分。

但出乎意想的是,通用推理和代码数学鸿沟的教养幅度也很大:BBH大幅教养5.0分,ARC-Challenge教养3.7分,DROP教养3.3分,HumanEval教养3.0分,MATH教养2.4分,GSM8K教养2.2分。

团队用LogitLens和CKA分析揭示了原因。

Engram让模子的早期层不再需要作念特征组合的“挑夫活”,KL散度弧线泄漏Engram模子的估量拘谨速率明显更快。更直不雅的根据来自CKA同样度矩阵,Engram-27B第5层的表征,和MoE基线第12层的表征最为同样。

这意味着Engram履行上“加深”了网罗的灵验深度,省下来的层数被用于更复杂的推理任务。

Engram-40B进一步增多驰念参数后,大部分任务性能合手续教养,且锤真金不怕火后期耗损仍不才降,阐明驰念容量还未满盈,后续可不息扩大。

另外长高下文场景的教养尤为显耀。

在RULER测试集上,Multi-Query NIAH从84.2跃升到97.0,Variable Tracking从77.0教养到89.0。

论文阐明注解说,Engram把局部依赖建模卸载给了查找操作,开释了小心力容量去存眷全局高下文。

百亿参数表放CPU上,延伸险些没影响接下来又到了喜闻乐道的软硬集合工程优化样子。

在锤真金不怕火阶段,词表范畴会高达100B参数,单个GPU存不下,必须拆分到多个 GPU 上,需要All-to-All通讯机制,让所有这个词 GPU 之间相互传递需要的驰念片断。

在推理阶段把词表卸载到CPU内存,同期又弗成让驰念调用拖慢预计节律。

和MoE的动态路由不同,Engram的查找索引只取决于输入token序列,十足不错提前预计。

这个详情味让团队粗略把浩大的镶嵌表放到CPU内存里,用PCIe异步预取,让通讯和前边层的预计类似。

具体通过把Engram模块插在Transformer网罗的特定层,GPU预计前一层的同期,CPU预取现时层需要的Engram驰念,等GPU算完前一层,所需的驰念也一经传输到位。

实验径直把一个1000亿参数的Engram表放到CPU内存,在H800上跑推理。4B密集模子的蒙眬量从9031 token/s降到8858 token/s,8B Dense模子从6315 token/s降到6140 token/s,独特支出齐在3%以内。

当然谈话N-gram自然校服Zipfian分别,少许数高频模式占据绝大多数探问量。这意味着不错预备多级缓存:高频镶嵌放GPU显存,中频放CPU内存,长尾放NVMe SSD,把灵验延伸进一步压缩。

DeepSeek团队在论断中写谈:

Engram将 “硬件感知恶果” 开拓为中枢预备原则:其详情味寻址机制辅助存储与预计的解耦,粗略将海量参数表卸载至主机内存,且推理支出可忽略不计。咱们觉得,条款驰念将成为下一代稀少模子中不可或缺的建模基元。

DeepSeek的下一代稀少模子,已被曝光将在春节前发布,敬请期待。

论文地址:

https://github.com/deepseek-ai/Engram/blob/main/Engram_paper.pdf